Los científicos de datos están entre los perfiles más buscados actualmente en el mercado laboral informático.

¿Por qué las empresas tienen tanto interés en los científicos de datos?

Por que necesitan extraer verdades y descubrir conocimientos críticos de negocios a partir de enormes cantidades de datos. Además necesitan hacerlo a gran velocidad, para ganarles a sus competidores. El científico de datos es quien sabe cómo lidiar con esas grandes cantidades de información y cómo extraer de ella lo que las empresas necesitan.

Un buen científico de datos debe reunir conocimientos de informática, modelado/análisis de datos, estadísticas, matemáticas y machine learning, además de contar con un sentido empresarial sólido. Con este arsenal de habilidades, el científico de datos puede encontrar respuestas a las grandes preguntas que ayudan las organizaciones a tomar mejores decisiones.

¿Cuál es la aplicación práctica de las ciencias de datos?

Hoy en día, las ciencias de datos se aplican con finalidades muy dispares. Puede ser ayudar en la búsqueda de nuevos tratamientos para la diabetes, o identificar e interceptar amenazas de seguridad. El análisis exhaustivo de grandes cantidades de datos puede facilitar notablemente dichas tareas. Es por eso que tanto empresas como agencias gubernamentales buscan constantemente contratar profesionales de las ciencias de datos, puesto que son ellos quienes tienen las llaves para develar conocimientos ocultos en océanos de Big Data.

Responsabilidades del científico de datos

Normalmente, un científico de datos interviene cuando en una organización surge una necesidad de respuestas que pueden extraerse de algún repositorio de información. El científico de datos debe poder decir si efectivamente esas respuestas pueden encontrarse en el repositorio de información y cuánto esfuerzo llevará encontrarlas.

¿Cuánto gana un científico de datos?

Fuente: Glassdoor España

En España, entre 24 mil y 50 mil euros al año.

Es probable que el repositorio de información no exista como tal, entonces el científico de datos deberá identificar las fuentes de donde pueden obtenerse esos datos, diseñar un repositorio y crear algoritmos o procesos que nutran ese repositorio con la información necesaria. Una parte importante del trabajo de un científico de datos implica comprender los objetivos de negocio para determinar la mejor forma de emplear los datos para cumplir con esos objetivos.

Si necesitas elegir un equipo con el que trabajar, te aconsejo leer sobre las mejores notebooks para ciencia de datos.

¿Cómo es el proceso de recopilación y análisis de datos?

Cada proyecto tiene sus particularidades, pero se puede generalizar la tarea de un científico de datos en cuanto a los procesos de recopilación y análisis, resumiéndolos en los siguientes pasos:

1. Descubrimiento

Entrevistar a todos los involucrados en el negocio y hacer las preguntas adecuadas para comprender plenamente lo que se espera como resultado del análisis de datos.

2. Adquisición de datos

Conectar las fuentes de datos y automatizar los mecanismos de adquisición, para que el repositorio de información se mantenga actualizado.

3. Limpieza de datos

Correr procesos que depuren la información obtenida en el paso anterior, corrigiendo inconsistencias, eliminando datos redundantes, eliminando datos erróneos y generando información resumida.

4. Integración y almacenamiento de datos

Una vez que la información se encuentra depurada, el científico de datos debe darle su estructura final y decidir la forma en que la información quedará almacenada. Este paso es muy importante, ya que según la forma en que los datos estén integrados y almacenados, dependerá que se puedan utilizar adecuadamente para el análisis.

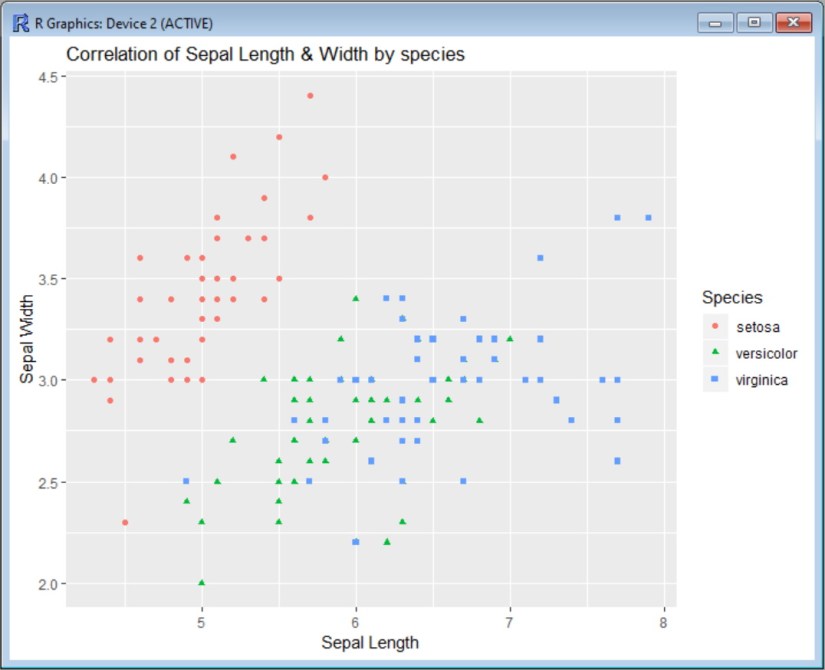

5. Investigación / análisis exploratorio

En esta etapa, el científico de datos explora los datos para descubrir patrones, detectar anomalías, poner a prueba hipótesis y verificar supuestos. Las herramientas requeridas en esta etapa son fórmulas estadísticas y representaciones gráficas.

6. Selección de modelos y algoritmos

Hay muchos algoritmos y modelos de análisis aplicables sobre un conjunto de datos, y saber cuál usar es algo que se aprende con el tiempo y con la experiencia. A partir de este punto, se puede diferenciar a un verdadero científico de datos de uno improvisado. El sitio KDnuggets ofrece una útil guía de algoritmos y modelos clave para ciencia de datos.

7. Aplicar técnicas específicas de data science

Las técnicas que se aplican en este paso son aprendizaje automático (machine learning), modelado estadístico e inteligencia artificial. Es en este paso cuando el científico de datos despierta el asombro y la admiración de sus empleadores, ya que es cuando se obtienen insigths y predicciones que tienen el potencial de cambiar el curso de los acontecimientos.

8. Medir y mejorar los resultados

Este es un paso de validación, en el que los descubrimientos y predicciones obtenidos en el paso anterior se contrastan con la realidad.

9. Presentar los resultados

Cuando se llega a este punto, en realidad todo el trabajo está hecho, y sólo resta mostrarlo de una forma convincente. Para ello no se requieren habilidades científicas, sino más bien capacidad para comunicarse en forma efectiva.

Terminado el proceso de recopilación y análisis, sólo resta revisar el trabajo hecho, aprender de los errores (si los hubo) y de los comentarios recibidos, y volver a empezar, buscando el siguiente desafío.

Carreras relacionadas con las ciencias de datos

Hay distintos perfiles, roles y títulos asociados con las ciencias de datos, ya que no siempre las empresas que buscan cubrir puestos de este estilo piden específicamente un Científico de datos. Cuando sí lo hacen, se espera que el título de cientifico de datos corresponda a una persona capaz de diseñar procesos para el modelado de datos y crear algoritmos y modelos predictivos, y llevar a cabo análisis personalizados de grandes volúmenes de información.

Otro título más común que el de científico de datos es el de Analista de datos. El analista centra su trabajo en manipular grandes conjuntos de datos, exprimiéndolos para identificar tendencias valiosas para business intelligence. Su objetivo es llegar a conclusiones significativas que sirvan de soporte a la toma de decisiones comerciales estratégicas.

Luego está el título de Ingeniero de datos. Su trabajo se enfoca principalmente en obtener datos de fuentes dispares, limpiándolos, organizándolos, resumiéndolos y guardándolos en repositorios.

El rol del Arquitecto de datos es similar al del ingeniero, pero enfocado más específicamente en diseñar las arquitecturas de datos que sostienen a una organización.

Es común que varios de los títulos mencionados estén combinados en unos pocos roles, o incluso en uno solo. Pero sus responsabilidades son diferentes. Por ejemplo, los data scientist desarrollan procesos para modelar datos, mientras que los analistas de datos examinan la información para identificar tendencias y sacar conclusiones. Debido a la naturaleza más técnica de la ciencia de datos, el rol de un científico de datos a menudo se considera de más alto nivel que el de un analista; sin embargo, ambos puestos pueden conseguirse con antecedentes educativos similares.

Habilidades de los científicos de datos

Los empleadores que ofrecen puestos de trabajo en las ciencias de datos esperan que los candidatos reúnan un conjunto de habilidades clave para hacer bien su trabajo. Estas habilidades se dividen en dos: «duras» y «blandas».

Habilidades «duras»

Las habilidades «duras» son aquellas que se adquieren con una formación en ciencias exactas, como matemáticas, estadísticas y ciencias de la computación. Las licenciaturas (bachelor’s) o los máster en cualquiera de estas ciencias exactas llaman inmediatamente la atención de los reclutadores para puestos en data science.

Entre estas habilidades, la principal que todo cientifico de datos debe tener es el análisis estadístico. Esta habilidad es esencial para saber cómo obtener muestras significativas de información, particularmente en ambientes de Big Data, y cómo analizarlas para detectar patrones y anomalías. Entre todas las habilidades de un científico de datos, los conocimientos estadísticos son probablemente los más difíciles de aprender, pero son los que hacen la diferencia en una postulación para un trabajo.

La segunda habilidad más importante es el conocimiento de ciencias de la computación. Todo data scientist debe dominar cuestiones clave de la computación, como sistemas de bases de datos, ingeniería de software, análisis numérico e inteligencia artificial.

La programación es otra habilidad esencial que se busca en un data scientist. La capacidad para trabajar con los lenguajes de programación SQL, Python y R en ambientes de Big Data es decisiva para los trabajos de data science.

Los reclutadores más exigentes pedirán también que sus aspirantes tengan habilidades en los terrenos de la inteligencia artificial y el aprendizaje automático. A pesar de que se habla mucho de estas dos habilidades, por el momento son pocas la organizaciones donde se usan en forma intensiva. Pero, como mínimo, es necesario conocer sus fundamentos y tener idea de cómo utilizarlas para crear algoritmos y modelos que permitan que una computadora aprenda a detectar patrones ocultos en los datos con mínima ayuda humana.

Habilidades «blandas»

A diferencia de las habilidades «duras», las «blandas» tienen que ver con una clase de conocimiento que no se adquiere en las principales carreras relativas a las ciencias de datos. Las habilidades blandas se adquieren en cursos cortos, o simplemente, con la experiencia en ámbitos laborales y sociales.

Una habilidad importante dentro de este grupo es la narración de historias de datos (data storytelling). Un data scientist no sólo debe saber cómo encontrar información valiosa; también debe saber cómo mostrarla, especialmente cuando debe hacerlo ante una audiencia no técnica. Hay cursos y hasta carreras cortas sobre data storytelling que enseñan a los data scientists a comunicar sus descubrimientos de formas entendibles y que despierten el interés de la audiencia.

Otra habilidad apreciada en un data scientist es el pensamiento analítico (analytical thinking). En el contexto de data science, el pensamiento analítico se orienta a mejorar los procesos para mejorar su productividad y aumentar sus probabilidades de éxito. Es común que, si tenemos habilidades analíticas, las usemos muchas veces sin saberlo. En cada ocasión en que observamos, interpretamos y formulamos nuevas ideas estamos empleando nuestras habilidades de pensamiento analítico.

También el pensamiento crítico (critical thinking) es una habilidad esencial para todo data scientist. Esta forma de pensamiento consiste en cuestionar la información, en lugar de aceptarla ciegamente. Los profesionales de las ciencias de datos que cuentan con capacidad de pensamiento crítico ponen en duda las obviedades y buscan justificaciones que ayuden a comprender mejor los hechos y a tomar mejores decisiones.

La visión de negocio es importante para un data scientist, para que su trabajo esté alineado con los objetivos de quien lo contrata.

Finalmente, las habilidades interpersonales también son apreciadas en un perfil de científico de datos. Generalmente, cuando se habla de científicos, uno se imagina una persona despeinada, con ojos desorbitados, encerrado en un laboratorio. El científico de datos no concuerda con esta imagen. Por el contrario, el data scientist debe ser comunicativo y debe saber transmitir ideas ante audiencias diversas, en todos los niveles de una organización.

¿Dónde estudiar ciencias de datos?

Los títulos de maestría (Másters) se obtienen mediante estudios especializados en un campo de investigación o un área de práctica profesional. Comúnmente insumen entre uno y cuatro años, y requieren un título previo (un título de grado o Bachelor’s) en alguna carrera afín. Las maestrías demuestran un alto nivel de dominio de la materia, y para graduarse suele ser necesario realizar un trabajo de investigación, a partir del cual se presenta y defiende una tesis.

Casi todas las universidades ofrecen másters en ciencias de datos. En el sitio Keystone Master Studies pueden encontrarse literalmente cientos de opciones para hacer másters en ciencias de los datos en todo el mundo. Lo bueno es que muchos de los cursos son en línea, lo que nos permite cursar en una universidad de Alemania, Australia o Estados Unidos desde cualquier parte del planeta.

Estas son algunas opciones de cursos de ciencias de los datos en español:

Máster en Business Intelligence y Data Management

El Máster en Business Intelligence y Data Management es brindado por INESDI Business School (Madrid, España). Se trata de un curso en línea que aporta conocimientos para llevar a cabo una gestión analítica de datos, cubriendo tecnologías avanzadas de Big Data. Se inicia en noviembre de 2021 y tiene una duración de 12 meses, a tiempo parcial. El costo es de 6800 euros.

Máster en Data Science y Deep Learning

El Máster en Data Science y Deep Learning de MIOTI Tech & Business School (Madrid, España) se divide en dos programas. El primero es el Máster en Data Science y Big Data, donde se aprende lo básico de la ciencia de datos, desde el preprocesamiento hasta algoritmos de analítica predictiva, incluyendo conocimientos de estadística y lenguaje Python.

El segundo es el Máster en Deep Learning, con el que se aprende a aplicar las más recientes tecnologías de aprendizaje automático y profundo en disciplinas de análisis predictivo y reconocimiento de imágenes, voz y textos. La modalidad puede ser presencial o en línea. Se inicia en septiembre de 2021 y tiene una duración de 9 meses, pudiéndose cursar a tiempo completo o parcial. El costo es de 12.750 euros.

Máster en Big Data & Analytics Part Time

El Máster en Big Data & Analytics Part Time es brindado por EAE Business School (Barcelona, España). Su programa está creado para enseñar a los alumnos cómo convertir las nuevas tecnologías en ventajas para sus empresas o proyectos. Ofrece una sólida formación en Business Intelligence y enseña liderazgo de proyectos de tecnologías de la información. La duración es de 12 meses, a tiempo parcial, y la modalidad es presencial.

Máster en Big Data & Business Analytics (MBDA)

El Máster en Big Data y Business Analytics (MBDA) es dictado por ESIC Business & Marketing School (Madrid/Barcelona, España). Aporta una visión profunda y transversal del Big Data, enseñando a usar las tecnologías para el procesamiento y diseño de arquitecturas de datos junto a diferentes técnicas analíticas para obtener el valor requerido por las áreas de negocio. El curso aplica una metodología de «learning by doing», con prácticas actuales de data science. La modalidad es presencial y a tiempo completo, con una duración de 11 meses. El costo es de 16,200 euros.

Máster en Data Science y Business Analytics

el Máster en Data Science y Business Analytics es un curso para profesionales dictado por IMF Smart Education en colaboración con la Universidad Nebrija (Madrid, España). El programa enseña las competencias necesarias para entender y extraer valor de los datos de que dispone una empresa, desde una perspectiva de análisis y gestión. Se ofrece en modalidad mixta (en campus o en línea), la duración es de 1 año y su costo es de 17.000 euros para la opción presencial y de 12.000 euros para la opción en línea.

Herramientas fundamentales para el data scientist

En el arsenal de un científicod e datos no pueden faltar los frameworks de Big Data. Si quisiéramos, por ejemplo, analizar los datos que generan los usuarios de Facebook durante un mes – fotos, videos, mensajes, vínculos, etc. – debemos tener en cuenta que cada día los usuarios añaden más de 500 terabytes de datos a la red social. Para manipular esa enorme cantidad de datos de manera eficaz, hace falta un framework capaz operar sobre una arquitectura distribuida. Hay dos frameworks que lideran este mercado: Hadoop y Spark.

Hadoop

Como framework de Big Data, Hadoop se ocupa de las complejidades asociadas con la obtención, el procesamiento y el almacenamiento de grandes cantidades de datos. Hadoop opera en un entorno distribuido, compuesto por clústers de computadoras que procesan algoritmos simples. Existe un algoritmo de orquestación, llamado MapReduce, que divide las tareas grandes en partes pequeñas y luego las distribuye entre los clústeres disponibles.

Hadoop se recomienda para repositorios de datos de clase empresarial que requieren acceso rápido y alta disponibilidad dentro de un esquema de bajo costo. Para mantener este framwork en funcionamiento se necesita un administrador de Linux con un conocimiento profundo de Hadoop.

Spark

Otro nombre importante en procesamiento de Big Data es Spark. El motor Spark fue diseñado para superar a Hadoop en términos de velocidad de análisis y facilidad de uso. Aparentemente, logró este objetivo: algunas comparaciones dicen que Spark se ejecuta hasta 10 veces más rápido que Hadoop cuando trabaja en disco y 100 veces más rápido en memoria. También requiere una menor cantidad de máquinas para procesar la misma cantidad de datos.

Además de la velocidad, otro beneficio de Spark es su compatibilidad con el procesamiento de streams. Este tipo de procesamiento de datos, también llamado procesamiento en tiempo real, implica una entrada y salida continua de datos.

Herramientas de visualización

Una broma común entre los científicos de datos dice que, si torturas a los datos durante el tiempo suficiente, te confesarán lo que necesitas saber. En este caso, “tortura” significa manipular los datos transformándolos y filtrándolos, para visualizarlos mejor. Y ahí es donde entran en escena las herramientas de visualización de datos. Estas herramientas toman datos preprocesados de múltiples fuentes y muestran sus verdades reveladas en formas gráficas y comprensibles.

Hay literalmente cientos de herramientas que entran en esta categoría. El más utilizado es Microsoft Excel y sus herramientas de gráficos. Los gráficos de Excel son accesibles para cualquier persona que use Excel, pero tienen una funcionalidad limitada. Lo mismo se aplica a otras aplicaciones de hojas de cálculo, como Google Sheets y Libre Office.

Hay herramientas más específicas, especialmente diseñadas para inteligencia empresarial (BI) y análisis de datos, como por ejemplo Power BI, Tableau y QlikView.

Power BI

Power BI puede obtener datos desde diversas fuentes, como archivos de texto, bases de datos, hojas de cálculo y muchos servicios de datos en línea. Con todo eso, Power BI genera tableros (dashboards) con gráficos, tablas, mapas y muchos otros objetos de visualización. Los objetos del tablero son interactivos, lo que significa que se puede hacer clic en una serie de datos en un gráfico para seleccionarla y usarla como filtro para los otros objetos en el tablero.

Power BI es una combinación de una aplicación de escritorio de Windows (parte del paquete Office 365), una aplicación web y un servicio para publicar los tableros en la web y compartirlos con otros usuarios.

Tableau

Tableau es otra opción para crear paneles interactivos a partir de una combinación de múltiples fuentes de datos. También ofrece una versión de escritorio, una versión web y un servicio en línea para compartir los paneles que genera. Funciona de forma natural «con tu forma de pensar» (como afirman sus creadores) y es fácil de usar para personas no técnicas, lo que se enfatiza a través de muchos tutoriales y videos en línea.

Algunas de las características más destacadas de Tableau son sus conectores de datos ilimitados, sus datos en vivo y en memoria, y sus diseños optimizados para dispositivos móviles.

QlikView

QlikView ofrece una interfaz de usuario limpia y simple para ayudar a los analistas a descubrir verdades a partir de diversas fuentes de datos, mediante elementos visuales que son fácilmente comprensibles para cualquier usuario.

Esta herramienta es conocida por ser una de las plataformas de inteligencia empresarial más flexibles. Proporciona una función llamada Búsqueda asociativa, que permite mantener el foco en los datos más importantes, evitando perder tiempo buscándolos.

QlikView permite colaborar entre múltiples usuarios en tiempo real, realizando análisis comparativos. Todos los datos pertinentes se pueden combinar en una aplicación, con funciones de seguridad que restringen el acceso a los datos.

Lenguajes de programación

El conocimiento del lenguaje SQL es fundamental para trabajar con bases de datos relacionales. Pero existen otros lenguajes con un enfoque más directo en la ciencia de datos, como por ejemplo Python y R.

Python

Python es un lenguaje de programación de alto nivel, interpretado y de propósito general, orientado al desarrollo rápido de aplicaciones. Su sintaxis es simple y fácil de aprender, lo que acorta la curva de aprendizaje. Es el lenguaje preferido para la ciencia de datos por su potencial de scripting, su portabilidad y rendimiento. También es un buen punto de partida para científicos de datos que planean experimentar antes de lanzarse al trabajo de procesamiento de datos «duros», y que desean desarrollar aplicaciones completas.

Existe una gran oferta de libros en español para aprender a programar en Python y de entornos integrados de desarrollo (IDE) para Python.

R

El lenguaje R se utiliza principalmente para procesar datos estadísticos y representarlos gráficamente. No está pensado para el desarrollo de aplicaciones completas, pero se ha vuelto muy popular por su potencial para minería y análisis de datos.

Gracias a una biblioteca en constante crecimiento de paquetes gratuitos que amplían su funcionalidad, R es capaz de realizar toda clase de procesamiento de datos, incluyendo modelado lineal y no lineal, clasificación, pruebas estadísticas, etc.

R tiene una curva de aprendizaje pronunciada, pero en cuanto se domina su filosofía y su sintaxis, se puede desatar su gran potencial para analizar grandes cantidades de datos.

Bienvenido a las ciencias de los datos

Si has leído hasta aquí, ya debes tener una idea clara de lo que significa ser un científico de datos. Si te interesa incursionar en el mundo de las ciencias de datos, ya sabes qué estudiar, qué leer y cómo prepararte para conseguir un trabajo dentro de esta profesión.

Escritor y periodista especializado en tecnología, desde el año 1992.

3 comentarios en «Cómo es el trabajo de un científico de datos»